Data warehouse : réussir grâce à l’analyse du Big Data

Les systèmes d’aide à la décision sont une longue tradition dans le monde des affaires. Depuis les années 1960, les entreprises utilisent des méthodes analytiques afin d’obtenir des données dites décisionnelles ou utiles. L’objectif est de soutenir le management avec des rapports, des modèles et des prévisions basés sur des données pour l’orientation stratégique des processus d’affaires et l’aide à la décision.

Les systèmes d’information analytique qui fournissent les fonctionnalités correspondantes regroupent des concepts tels que le MIS (Management Information Systems), le DSS (Decision Support Systems) ou l’EIS (Executive Information Systems) qui sont souvent difficiles à distinguer les uns des autres et sont regroupés, depuis les années 1990 dans la pratique et dans la commercialisation des produits correspondants, sous le terme global d’informatique décisionnelle : en anglais Business Intelligence (BI).

Business Intelligence (BI) ou informatique décisionnelle, sont des termes génériques pour la préparation et l’analyse assistées par ordinateur des données brutes de l’entreprise. L’informatique décisionnelle ou BI est censé générer des connaissances qui servent de base à l’orientation stratégique de l’entreprise.

La base de données des systèmes d’aide à la décision dans le cadre de l’informatique décisionnelle est aujourd’hui généralement apportée par un entrepôt de données central, connu aussi sous le nom de data warehouse. Nous allons voir les bases des systèmes de data warehouse ainsi que l’architecture de référence d’un tel système d’information, et présentons les éditeurs connus de solutions DWH commerciales ainsi que les alternatives open-source gratuites.

Qu’est-ce qu’un data warehouse ?

Un data warehouse (DWH) est par définition un système de base de données distinct d’un système de traitement de données opérationnelles, dans lequel les données provenant de diverses sources, parfois même très hétérogènes, sont combinées, compressées et archivées à long terme. De nombreuses entreprises transfèrent régulièrement les données historiques des systèmes de traitement des données opérationnelles vers un tel entrepôt de données et les préparent pour des accès ultérieurs afin d’effectuer des analyses stratégiques dans le cadre de l’informatique décisionnelle (ou BI). Les données opérationnelles deviennent donc des données décisionnelles :

- Données opérationnelles : ce sont des informations orientées transactions générées dans les entreprises par l’activité quotidienne et produites notamment par les systèmes d’administration et de facturation. Les sources classiques de données sont les systèmes de traitement de données opérationnelles comme par exemple les programmes de comptabilité, les progiciels de gestion intégré (PGI ou ERP pour Entreprise Resource Planning) ou les systèmes d’information et de commande.

- Données décisionnelles : lorsque les données opérationnelles sont rassemblées en un seul endroit, stockées sur le long terme et préparées pour l’analyse, on parle alors de données décisionnelles.

Un DWH apporte aux analystes un aperçu complet des ensembles de données hétérogènes et permet l’agrégation des statistiques opérationnelles dans le cadre du traitement analytique en ligne (en anglais Online Analytical Processing, OLAP). En tant que point central de collecte de toutes les données d’entreprise pertinentes, l’entrepôt de données est utilisé pour la gestion des connaissances en interne. Les utilisateurs n’ont généralement accès qu’en lecture seule. Un DWH sert de base de données pour les méthodes d’exploration de données (data mining) et reste le support à toutes les études relatives à la gestion de la performance et à l’orientation stratégique de l’entreprise.

Structure d’un DWH : architecture d’un data warehouse

Le processus de gestion et d’analyse d’un DWH est appelé data warehousing (ou entreposage de données) et comporte les phases suivantes :

- Acquisition et intégration des données

- Stockage des données

- Evaluation et analyse des données

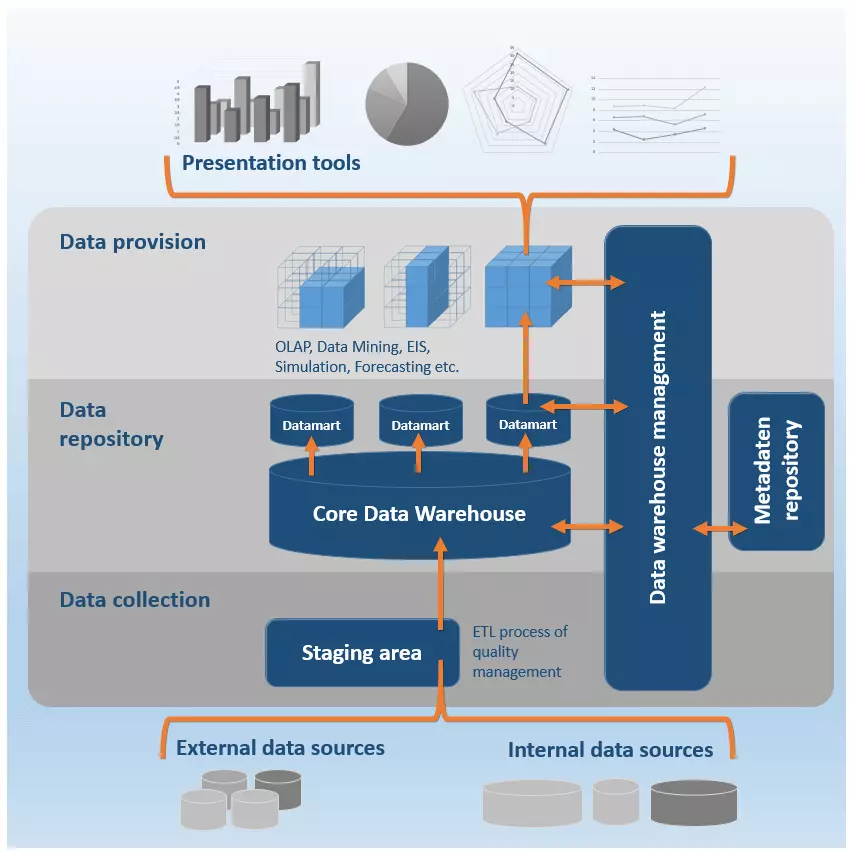

Les phases du data warehousing se reflètent dans la structure type, l’architecture dite de référence des systèmes d’entreposage des données. Bien que l’architecture du système varie selon le produit et l’éditeur, sa structure technique repose sur un schéma modulaire qui peut être divisée en trois niveaux :

- Collecte des données (data collection)

- Dépôt et archivage des données (data repository)

- Fourniture et transmission des données (data provision)

Il existe en outre une composante de contrôle centralisée : c’est le data warehouse manager. Ce dernier affecte des fonctions spéciales d’administration à chaque niveau du DWH. Les composants individuels d’un data warehouse ne doivent pas nécessairement provenir d’un seul fournisseur ; en effet, les services respectifs peuvent également provenir de différents logiciels ou solutions individuelles.

L’illustration suivante représente schématiquement l’architecture de référence d’un DWH.

Niveau de collecte des données (data collection)

Avant que les données puissent être chargées vers le DWH, les informations souvent très hétérogènes doivent d’abord être unifiées pour une présentation uniforme. Un entrepôt de données s’alimente de manière autonome à partir des sources de données internes d’une entreprise ainsi que des sources de données externes pertinentes :

- Données internes : système d’exploitation : progiciel de gestion intégré (PGI ou ERP), systèmes de gestion de la relation client (CRM) ; bases de données opérationnelles ; système de gestion de contenu (CMS) ; bases de données orientées texte, fichiers plats (par exemple Excel, CSV, fichiers textes), emails, etc.

- Données externes : applications et systèmes de fournisseurs de services externes, sites Web, médias sociaux, services de Cloud, etc.

Les systèmes au niveau de l’enregistrement des données fournissent des interfaces pour les systèmes d’exploitation des entreprises et sont utilisés dans la première phase du data warehousing. L’acquisition et l’intégration des données sont deux fonctions centrales de ces composants DWH.

Les techniques de collecte suivantes sont utilisées pour l’extraction et l’acquisition des données :

- Trigger ou déclencheur : si les systèmes opérationnels d’une entreprise prennent en charge les déclencheurs de base de données, ils peuvent alors être utilisés pour automatiser l’extraction des données. Les déclencheurs vous permettent de définir des opérations qui sont exécutées automatiquement lorsque certains événements se produisent. En règle générale, les événements déclencheurs se rapportent à des changements dans la base de données du système source, qui conduisent à une extraction des données modifiées dans le DWH.

- Fichiers journaux : si le système d’exploitation ne prend pas en charge le trigger ou déclencheur, le niveau d’acquisition des données d’un DWH peut contenir des programmes capables d’évaluer les fichiers journaux (ou fichiers log) des systèmes sources et d’extraire les opérations enregistrées dans ces derniers.

- Programme de monitoring : si pour l’extraction il n’est pas possible de recourir au déclencheur ou aux fichiers journaux, les programmes de monitoring sont alors généralement utilisés. Ces derniers extraient les changements dans l’ensemble de données d’un système d’exploitation à l’aide d’algorithmes qui créent des instantanés des données à surveiller (snapshots) à intervalles réguliers et les synchronisent avec les précédents.

Si aucune des techniques décrites ci-dessus n’est prise en charge, car l’accès aux données dans le système d’exploitation n’est pas possible, ces modifications doivent être enregistrées de manière indépendante et les modifications correspondantes communiquées à l’entrepôt de données.

En matière d’intégration de données, la plupart des DWH offrent des fonctionnalités OLAP qui permettent de présenter les fichiers dans des structures multidimensionnelles. Le traitement analytique en ligne (OLAP) est une méthode d’analyse utilisée pour comprimer les données et fichiers d’entreprises pertinents pour la gestion. Le fonctionnement est basé sur le processus ETL :

- E = Extraction : l’extraction des données consiste à extraire des informations pertinentes de diverses sources de données. Ceci peut être mis en œuvre comme une stratégie Push and Pull. Si les données sont extraites dans le cadre d’une stratégie Push, les sources de données sont encouragées à générer des extraits à intervalles réguliers et à les transmettre au DWH. Dans le cas d’une stratégie Pull, c’est le DWH qui initie, de sa propre initiative, l’extraction des données.

- T = Transformation : les données extraites sont ajustées lors d’une transformation et traduites da manière uniforme dans le format de la base de données cible.

- L = Loading (chargement) : la phase de chargement implique la sauvegarde des données transformées dans les bases de données cibles respectives du DWH.

Le niveau d’acquisition et de traitement de données d’un DWH peut contenir une zone dite de Staging Area (aussi appelée zone de préparation). Il s’agit d’une zone temporaire de la base de données dans laquelle les données à charger sont prétraitées. Un tel processus de traitement peut être particulièrement nécessaire dans les processus ETL complexes.

Comme un data warehouse rassemble des données provenant de sources très diverses, l’intégration des données est basée sur différents outils qui permettent la transformation et l’ajustement des données extraites. Ils peuvent être classés dans les catégories suivantes :

- Outils de migration de données : les programmes de migration de données vous permettent de définir des règles de transformation simples pour convertir des données sources hétérogènes en un format cible uniforme.

- Outils de nettoyage des données : pour le nettoyage des données, des programmes basés sur la logique floue (fuzzy logic) ainsi que les réseaux neuronaux artificiels sont utilisés. L’objectif est d’améliorer la qualité des données en éliminant les erreurs, les lacunes et les répétitions dans les ensembles de données grâce à l’implémentation de règles prédéfinies, d’algorithmes et de tables de correspondance (LUT). C’est ce que l’on nomme aussi le management de la qualité (Quality Management).

- Outils d’audit des données : les outils de vérification des données sont utilisés dans l’intégration des données pour déterminer les règles et les relations entre les données. En outre, les programmes de ce type vous permettent aussi d’identifier les données qui enfreignent les règles définies ce qui signifie qu’il s’agit probablement d’erreurs.

L’intégration des données est suivie par le transfert des données extraites dans la base de données centrale, le « core data warehouse ». Cette étape est supportée par des programmes qui offrent les fonctions suivantes :

- Vérification des conditions d‘intégrité

- Tri des données

- Calcul des agrégations

- Détermination des structures d’accès

- Partitionnement des données pour un accès efficace

Niveau de dépôt et d’archivage des données (data repository)

Le niveau d’archivage des données est un élément central de l’entrepôt des données. Il s’agit de ce que l’on nomme le « Core Data Warehouse ». Les données extraites sont généralement stockées dans le DWH sous forme de matrices multidimensionnelles, ce que l’on appelle des schémas en étoile ou en flocon, pour des analyses futures dans le cadre d’un archivage à long terme. Toutefois, cela fait rarement référence à l’ensemble du stock de données d’un DWH. Pour permettre une analyse efficace, il est donc d’usage de créer des segments de données de l’ensemble du répertoire, connus sous le nom de datamart (aussi nommé magasin de données).

Un datamart est une copie d’une partie d’une base de données, qui est généralement implémentée de façon non persistante comme stockage temporaire, intermédiaire. Dans certains cas toutefois, des datamarts dits indépendants sont aussi utilisés, ce qui permet de disposer en permanence d’une section, d’un extrait de données séparé à long terme.

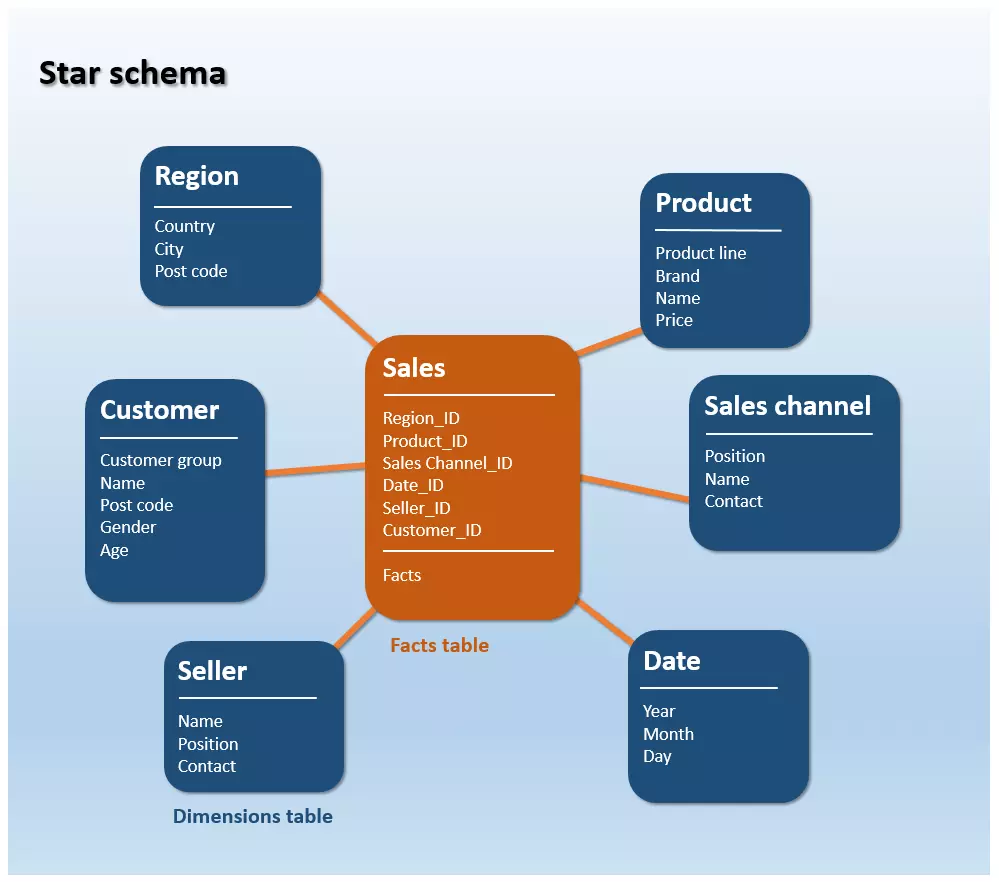

Un schéma en étoile est un type de diagramme entité-association ou Entity Relationship Diagram (ERD), c’est à dire une représentation graphique de la structure de table d’une base de données dans laquelle sont illustrées les différentes entités ainsi que leur relation entre elles. Le schéma en étoile est donc utilisé pour visualiser des structures de données multidimensionnelles.

Chaque schéma en étoile est constitué d’une table des faits et de plusieurs tables de dimension qui sont regroupés en forme d’étoile autour de la table de faits.

- La table de faits contient ce que l’on appelle les faits : chiffres clefs et résultats d’une société qui sont enregistrés en permanence (par exemple le chiffre d’affaires).

- La table de dimensions contient des attributs qui décrivent les données de la table de faits. Une table de dimension est un ensemble d’informations de référence sur les événements stockées dans la table de faits.

Dans le modèle de données en étoile (star schema), seule la table des faits est liée à toutes les tables de dimensions par des relations clefs étrangères. Les connexions entre les tables de dimensions individuelles ne sont pas établies. La figure suivante montre une représentation simplifiée d’une telle structure de données :

Dans le schéma en étoile ci-dessus, le fait « ventes » peut être représenté par exemple par rapport à un certain canal de vente, à un produit spécifique, à un vendeur, à une région ou bien en fonction de la période. Par exemple, une requête possible sur trois dimensions serait : quel est le chiffre d’affaires généré par un produit particulier en 2016 via le canal de la vente en ligne ?

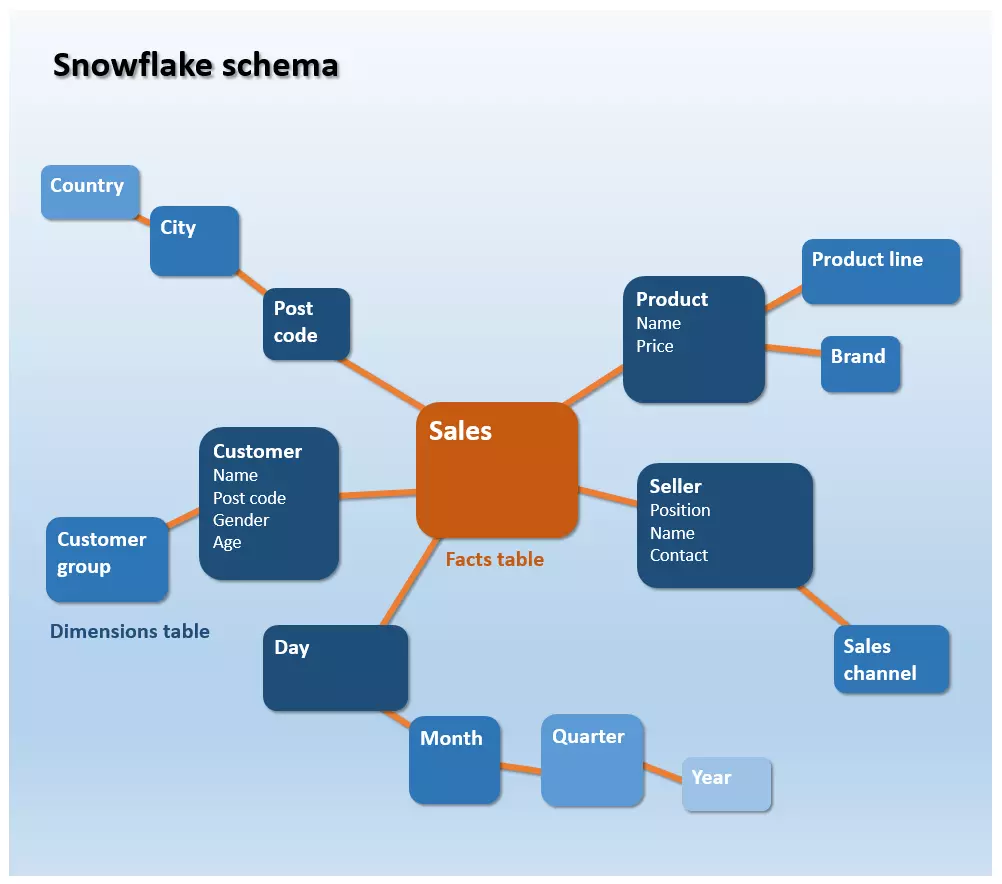

Le modèle de données dit « en flocon » (snowflake schema) est une variante du schéma en étoile. En effet, les tables de dimensions d’un schéma en étoile sont sous forme dénormalisée, alors qu’avec le schéma en flocon, les informations de référence sont stockées sous forme de 3D, les hiérarchies des schémas sont normalisées. Ainsi, les données sont classifiées et hiérarchisées, ce qui signifie que les informations redondantes sont externalisées et placées dans de nouvelles tables. Il en résulte une sorte de ramification distinctive qui prend alors l’aspect d’un flocon de neige.

Les schémas en flocon se caractérisent par une consommation d’espace de stockage plus faible que les schémas en étoile. Ceci résulte d’un stockage de données normalisé. Ici, la normalisation se réfère au transfert des colonnes vers de nouvelles tables dans le but d’éviter les doublons. L’élimination des redondances réduit aussi le coût de maintenance et de gestion des données : dans le meilleur des cas, chaque information n’apparaît qu’une seule fois et ne doit donc être placée qu’une fois dans le schéma.

Toutefois, si les données sont transférées dans des tables normalisées, ceci conduit inévitablement à des structures de données plus complexes, ce qui implique généralement des durées de requête plus longues. Si les analystes veulent accéder aux données d’un schéma en flocon, les tables de dimensions multi-niveaux doivent d’abord être liées dans le cadre d’une jointure.

une jointure est une opération de base de données qui permet de fusionner, dans certaines circonstances, des tables de base de données reliées via une clef étrangère.

Dans la pratique, la structure de données d’un DWH est généralement basée sur le schéma en flocon, tandis que les datamarts individuels sont implémentés en tant que schéma en étoile.

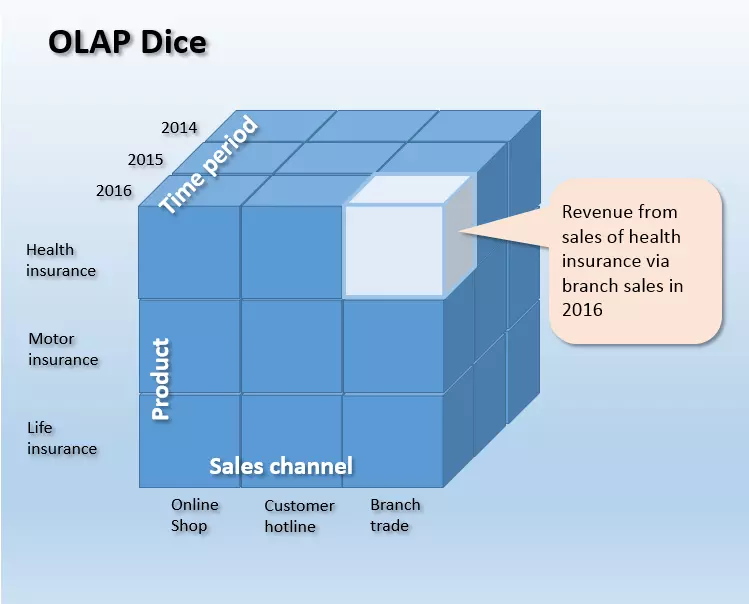

Dans les schémas en étoile ou en flocon, nous avons affaire à des tables de dimensions, car chaque table est vue comme une dimension d’un cube OLAP multidimensionnel. Ceci permet aux analystes de placer les faits stockés dans le DWH par rapport à autant d’informations de référence qu’ils le souhaitent, afin d’analyser les ratios commerciaux comme le chiffre d’affaires, de manière multidimensionnelle sur la base de divers aspects et de les examiner à différents niveaux de détail.

L’illustration suivante montre la représentation schématique d’un cube OLAP tridimensionnel dont les bords recouvrent les dimensions ligne de produit (product), canal de vente (sales channel) et la période (time period). La longueur des arêtes du cube est déterminée par le nombre de cellules. Chaque cellule du cube contient exactement une valeur, par exemple, le chiffre d’affaires de la ligne de produits d’assurance responsabilité civile (insurance liability) en 2016 via le canal de vente des succursales (indiqué en bleu clair dans l’illustration).

Le processus OLAP n’est pas limité à trois dimensions. Un tel cube de données est structuré de manière n-dimensionnelle et peut en théorie contenir autant de dimensions que vous le souhaitez.

en fonction de la technologie de stockage sur laquelle le Core data warehouse est basé, on distingue différents processus OLAP. Si le cube accède à des données à partir d’une base de données relationnelle, il est appelé ROLAP (Relationnal OLAP). Les cubes basés sur des bases de données multidimensionnelles sont appelés MOLAP (multi-dimensional OLAP).

Niveau de livraison des données

Ce niveau de données sert d’interface avec les applications finales et les outils de présentation, ce qui facilite l’analyse des données et les méthodes d’évaluation qui permettent d’extraire des informations des entrepôts de données et de les traiter sous différentes formes de présentation pour les utilisateurs finaux. La gamme comprend notamment les outils de rapports et d’interrogation, les outils de collaboration et d’exploration de données, le traitement analytique en ligne (OLAP), les systèmes d’information exécutive (EIS) et les outils de prévision et de simulation.

Outils de requêtes et de rapports

Les outils de reporting offrent à l’utilisateur final différentes fonctions pour créer des rapports standards prédéfinis (Predefined Reportings). Les rapports peuvent être automatiquement émis à intervalles réguliers ou sur demande. Pour que l’utilisateur final puisse facilement demander des renseignements au DWH, ces requêtes peuvent être prédéfinies à l’aide d’outils de recherche (query tools).

Outils de collaboration

Les outils de collaboration soutiennent la communication et la collaboration des utilisateurs finaux avec l’analyse des données. L’éventail des fonctions offert par cette gamme d’outils comprend, par exemple, la sauvegarde des annotations et l’échange des résultats d’analyse.

Outils de data mining

Le terme de data mining couvre toutes les méthodes d’analyse non dirigées et partiellement automatisées qui visent à identifier les modèles, tendances et relations pertinentes dans la base de données. Les outils d’exploration de données sont basés sur des méthodes statistiques et mathématiques ainsi que sur l’intelligence artificielle (AI) et les techniques d’apprentissage de la machine. La quantité de données que les entreprises génèrent, traitent et fusionnent dans un DWH à des fins d’analyse croît de manière exponentielle. Le volume moyen des données dans le monde double tous les deux ans. Dans ce contexte, les méthodes d’exploration des données prennent une importance croissante dans le cadre de l’entreposage de données.

Outils de traitement analytique en ligne (OLAP)

Parmi les outils d’analyse et d’évaluation des données disponibles, les applications OLAP se sont particulièrement imposées comme des interfaces utilisateurs standard pour le data warehousing. Les outils qui sont utilisés dans le contexte du traitement analytique en ligne apportent aux utilisateurs diverses fonctions afin de formuler des requêtes à l’entrepôt de données. Ils sont utilisés pour naviguer dans l’ensemble multidimensionnel de données.

L’affichage via OLAP permet de modéliser des données formatées en fonction d’un nombre quelconque de dimensions prédéfinies. Les analystes peuvent utiliser diverses opérations de base afin d’éditer un cube OLAP.

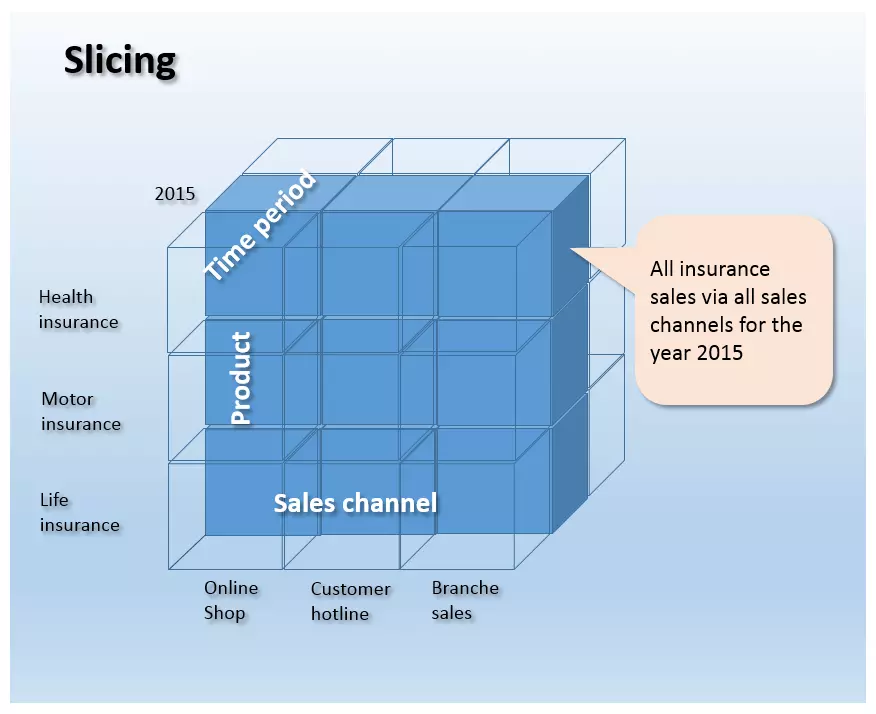

- Slicing : le « slicing » est un processus qui délimite une dimension d’un cube OLAP à un sous-ensemble. C’est une extraction d’un bloc du cube de données qui est visualisé séparément.

L’image suivante montre la dimension de la période (time period) avec la section de 2015 mise en évidence. Ainsi, la partie surlignée indique le chiffre d’affaires de tous les produits d’assurance vendus par tous les canaux de distribution au cours de l‘année 2015.

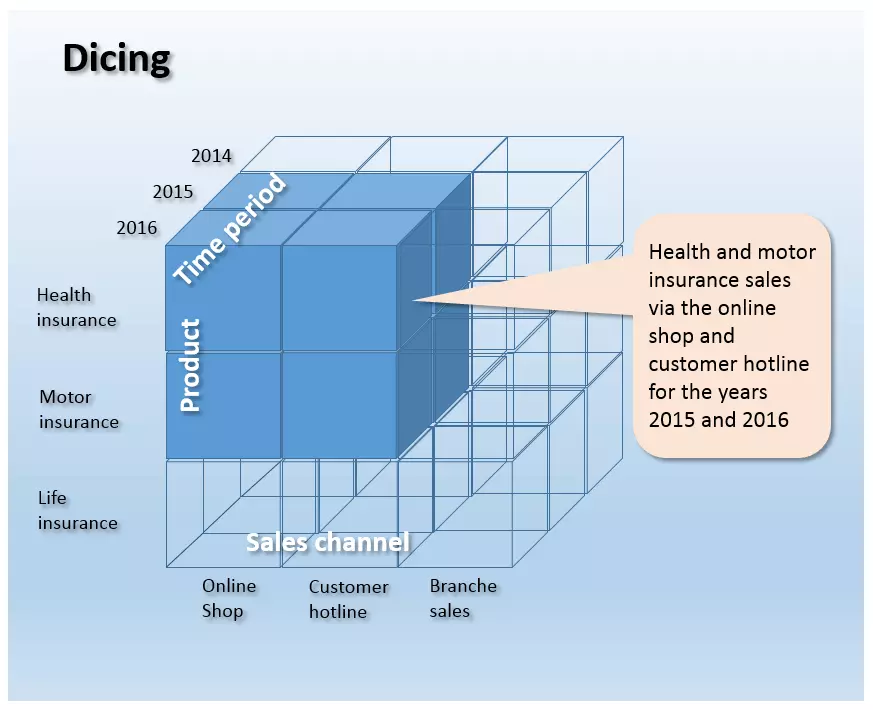

- Dicing : si un cube OLAP est découpé en plusieurs dimensions par des opérations simultanées de Slicing, on parle alors de « Dicing ». Le processus de Dicing crée un cube plus petit qui est alors un sous-ensemble du cube total.

L’illustration suivante montre une opération de dicing, où le cube total a été réduit à un sous-ensemble dans les trois dimensions.

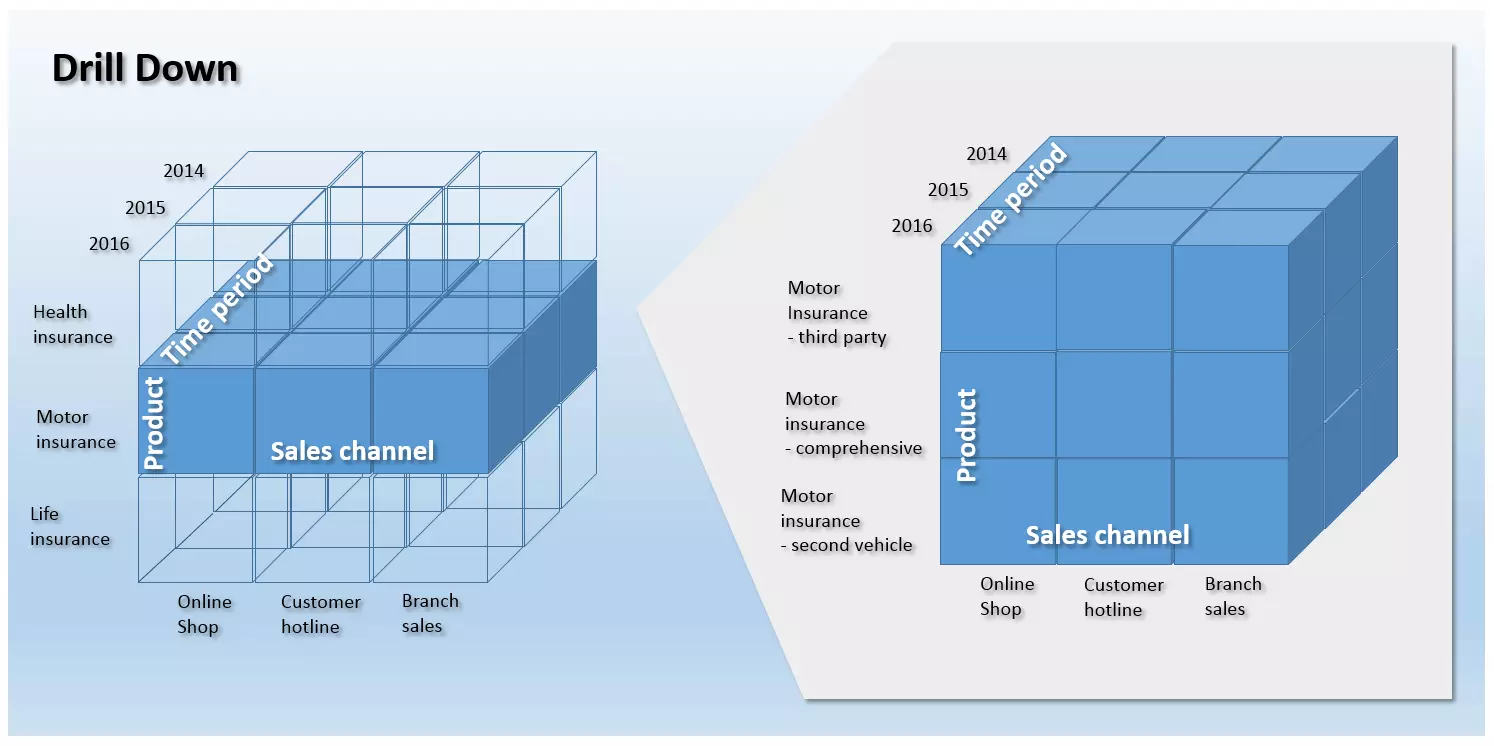

- Drill-down et roll-up : si les agrégats d’un objet d’information doivent être décomposés en valeurs plus détaillées, l’opération Drill-down ou forage vers le bas est alors utilisée. Cela permet aux analystes de zoomer sur un cube OLAP et d’augmenter ainsi la granularité des données ; c‘est donc une représentation plus détaillée. Au contraire, un roll-up ou forage vers le haut consiste à représenter les données du cube à un niveau de granularité supérieur et est donc utilisé pour comprimer les informations sur les niveaux hiérarchiques supérieurs. Le drill-down et le roll-up sont utilisés pour la navigation dans des structures hiérarchiques multidimensionnelles.

Le graphique suivant montre un drill-down de l’objet d’information chiffre d’affaire dans la dimension des lignes de produits. La granularité est augmentée de sorte que les chiffres d’affaires enregistrés dans le DWH peuvent être interprétés et analysés en fonction des produits individuels.

- Drill-out/Split : le drill-out (ou split ou division) permet aux analystes d’ajouter une dimension supplémentaire à un cube OLAP. Il en résulte des données plus détaillées. Cependant, contrairement à l’opération Drill-Down, le niveau de détail n’est pas augmenté en termes de granularité, mais c’est plutôt un gain d’information résultant de l’information de référence supplémentaire de la dimension ajoutée.

- Drill-in/Merge : en opposition au drill-out, le niveau de détail du cube OLAP est réduit en supprimant les dimensions. Contrairement au roll-up, la perte d’informations dans cette opération ne résulte pas d’un changement de plan de visualisation, mais de la perte d’informations dimensionnelles. La granularité reste donc la même.

- Drill-across : l’opération de données Drill-across ou « jointure » est aussi utilisée pour analyser l’ensemble de données. Alors que les opérations vues jusqu’à présent font toujours référence à un cube OLAP, la procédure de jointure est appliquée à plusieurs cubes de données afin de permettre des analyses globales. N’importe quel nombre de tables de faits avec au moins une dimension commune peut être analysé sur le même niveau hiérarchique et de granularité, tout en maintenant le niveau de visualisation.

- Drill-through : c’est une opération au cours de laquelle un analyste sélectionne une seule cellule d’un cube de données et l’examine au plus haut niveau de détail. Contrairement au drill-down, le drill-through accède aux données sources de la cellule du cube sélectionnée. Cela signifie que le résultat du Drill-through est dérivé des cellules du tableau qui sous-tendent la cellule du cube sélectionnée.

Executive Information System (EIS)

Comme pour OLAP, les outils EIS apportent aux utilisateurs différentes façons de formuler des requêtes et de modéliser les données. Cependant, contrairement à OLAP, le terme EIS est aujourd’hui surtout utilisé pour désigner les systèmes d’application complets et prêts à l’emploi qui fournissent des rapports prédéfinis pour certains domaines d’activité comme la vente, le marketing ou encore la planification financière.

Outils de prévision et de simulation

Les outils de prévision et de simulation permettent aux utilisateurs de mettre à jour les données stockées dans le DWH et de développer des modèles de prévision.

Data warehouse management

Des outils spéciaux sont actifs à tous les niveaux du DWH et sont regroupés sous le terme de warehouse management. Le rôle de ces composants consiste à mettre en place, maintenir et exploiter toutes les fonctions d’administration nécessaires à l’entreposage des données. Les principales tâches du « responsable DWH » sont la planification des processus DWH, la gestion des métadonnées, la gestion de la sécurité ainsi que la gestion du système.

- Scheduling : ceci comprend le contrôle des processus DWH. Les fonctions d’administration dans le contexte de l’ordonnancement peuvent être classées comme suit en fonction des niveaux de l’architecture de l’entrepôt des données :

- Collecte et entrée des données : au niveau de la collecte des données, le manager DWH est responsable de la conception et de la personnalisation des processus ETL. Des fonctions d’administration sont aussi prévues pour contrôler les mises à jour et la gestion de la qualité.

- Stockage et archivage des données : au niveau du stockage des données, le manager DWH surveille l’utilisation de la mémoire, construit des tables d’agrégation et effectue des opérations d’archivage et de sauvegarde.

- Fourniture et transmission des données : les fonctions d’administration à ce niveau comportent la gestion des utilisateurs et le suivi des temps d’exécution des requêtes.

- Collecte et entrée des données : au niveau de la collecte des données, le manager DWH est responsable de la conception et de la personnalisation des processus ETL. Des fonctions d’administration sont aussi prévues pour contrôler les mises à jour et la gestion de la qualité.

- Management des méta-données : le dépôt de métadonnées (metadata repository) est un élément central du manager DWH. Il contient toutes les informations nécessaires à la conception et au fonctionnement des informations relatives à la base de données du DWH. Les métadonnées stockées dans le référentiel comprennent, par exemple, la définition du schéma de base de données sous-jacent, des informations sur les structures de sauvegarde, les chemins d’accès avec la taille des fichiers, les méta-données sur la description des données sources, mais aussi les temps de mise à jour, les règles sur le nettoyage des données ainsi que la transformation des données, les index et les tables de partitions. En outre, le gestionnaire DWH s’occupe de l’échange des métadonnées entre les différentes composantes de l’entrepôt de données et apporte ainsi une base homogène pour les métadonnées.

- Gestion de la sécurité : le management de la sécurité comporte divers services d’authentification, d’autorisation des utilisateurs et de cryptage.

- Gestion du système : dans le cadre de la gestion du système, le manager DWH assure diverses fonctions d’administration pour le fonctionnement du DWH. Il s’agit par exemple du monitoring (performance, utilisation etc.), de l’archivage ou de la sauvegarde des données.

L’entreposage des données et la question de la protection des données

L’agrégation, le stockage à grande échelle de données opérationnelles, commerciales et clients dans un entrepôt de données et l’analyse de cette masse de données à l’aide de méthodes de data mining ou d’applications OLAP offrent aux entreprises des opportunités pour optimiser durablement leurs processus commerciaux. Outre les avantages des analyses de données pour la prise de décisions, certains tirent toutefois la sonnette d’alarme sur les risques importants de ces analyses de données en matière de protection de la vie privée.

Selon les critiques, les analyses qui permettent de créer des profils de personnalité et des prédictions automatisées de comportements et d’actions sont particulièrement sensibles. Le débat se concentre en effet sur le potentiel de manipulation de l’information à partir des analyses de données.

En France, le cadre légal qui régit l‘exploitation et le stockage des données et leur protection se trouve dans le texte de loi Informatique et Libertés. Ce cadre légal national est aussi renforcé au niveau européen avec le RGPD (règlement général sur la protection des données). Dans ce contexte, les conditions de bases suivantes s’appliquent au stockage et au traitement ultérieur des données à caractère personnel :

- Affectation et finalité des données personnelles : les données personnelles ne peuvent être collectées, stockées et traitées que dans le cadre d’objectifs légalement autorisés et d’accord mutuels. Les objectifs doivent être formulés avant la collecte. Mais selon certains défenseurs de la protection des données, le stockage de données personnelles dans un entrepôt de données s’écarte bien souvent de la finalité initiale d’utilisation et représente bien souvent un stockage abusif et contraire à l’objectif initial.

- Changement de finalité uniquement avec le consentement de l’intéressé : les modifications de la finalité de stockage des données personnelles ne sont autorisées qu’avec le consentement des personnes. Ces dernières doivent de plus être informées de la portée du consentement. Les procédures de collecte de données à caractère personnel doivent respecter le fait que les personnes puissent évaluer les risques et surtout exercer leurs droits. En effet, le consentement doit pouvoir être retiré à tout moment puisque d’après la loi, chacun doit pouvoir décider et contrôler les usages des données personnelles le concernant.

- Minimisation de la collecte : les systèmes de traitement et de collecte de données doivent être conçus de manière à collecter le moins de données à caractère personnel possible. Uniquement les données strictement nécessaires à la réalisation de l’objectif doivent être collectées. De plus, les procédures anonymisées voire pseudonymisées sont plus inoffensives et plus respectueuses.

- Un stockage permanent de données personnelles n’est pas autorisé lors de l’archivage de données personnelles. Les délais légaux de conservation doivent être respectés. Si ce délai est dépassé et prolongé sans autorisation, ce stockage devient alors illégal.

- Le profilage et les décisions individuelles automatisées : parfois les procédures de data mining sont utilisées dans le contexte des décisions individuelles automatisées. Or une telle approche, y compris le profilage, est désormais contraire au nouveau règlement européen sur la protection des données sauf dans des cas limités et si des mesures strictes sont prises pour garantir le respect des droits de la personne.

Il est recommandé aux éditeurs et aux utilisateurs d’utiliser des systèmes de stockage de données et de procédures de data mining basés sur des techniques qui respectent la protection des données et qui évitent le stockage de données à caractère personnel par le biais, par exemple, de l’anonymisation ou de la pseudonymisation.

Logiciels de data warehouse

L’entreposage de données a depuis longtemps cessé d’être réservé uniquement aux grandes entreprises. Les petites et moyennes entreprises (PME) voient aussi désormais un potentiel sur l’optimisation des processus d’affaires grâce à des analyses de données poussées. En sus des suites BI coûteuses et des solutions DWH complètes intégrées, des produits d’entrée de gamme à faible coût allant de services de Cloud flexibles à des applications open source sont depuis plusieurs années sur le marché. Ces produits ciblent en particulier les entreprises de taille moyenne.

Produits d’entreposage de données payants

Les logiciels commerciaux de BI (Business Intelligence) classiques se caractérisent généralement par une grande fiabilité, une gamme de services convenus dans le cadre d’accords de niveau de service (SLA pour Service Level Agreement) et une assistance professionnelle. Cependant, les utilisateurs doivent planifier un budget pour leur acquisition ou pour l’utilisation de ces services basés sur le Cloud.

La liste suivante donne un aperçu des produits de data warehousing payants des principaux fournisseurs et éditeurs (par ordre alphabétique).

| Editeurs de logiciels propriétaires | Produits d’entreposage de données |

|---|---|

| Amazon Web Services | Amazon Redshift |

| Cloudera | Cloudera Enterprise |

| Hewlett Packard Enterprise | HP Vertica, HP ArcSight Data-Platform, HP Haven OnDemand, HP IDOL, HP Key View |

| IBM | IBM Netezza, IBM PureData System, IBM InfoSphere DataStage |

| Microsoft | SQL Server, Microsoft Analytics Platform System, Azure HDInsight for Hadoop |

| Oracle | Oracle Business Intelligence, Oracle Database, Oracle Exadata Database Machine, Oracle NoSQL Database,Oracle TimesTen In-Memory Database, Oracle Big Data Appliance |

| Pivotal Software | Pivotal Greenplum, Pivotal Big Data Suite, Pivotal HDB (powered by Apache HAWQ), Pivotal HDP (OEM Hortonsworks Data Platform) |

| SAP | SAP NetWeaver Business Intelligence, SAP IQ, SAP HANA Enterprise Cloud |

| SAS | SAS Data Management, SAS Access Interface to Hadoop, SAS Federation Server, SAS Data Loader for Hadoop, SAS Event Stream Processing |

| Snowflake Computing | Snowflake |

| Teradata | Teradata Active Enterprise Data Warehouse, Teradata Data Warehouse Appliance, Teradata Appliance for Hadoop, Teradata Integrated Big Data Platform, Teradata Aster Big Analytics Appliance |

Solutions open-source

En plus des produits payants, le marché des logiciels de BI offre différentes solutions open source qui apportent gratuitement des fonctionnalités d’entreposage de données. Vous trouverez ci-dessous une vue d’ensemble des outils open source de Business Intelligence. Le tableau montre non seulement les programmes BI open source les plus courants, mais aussi l’étendue des applications offertes par chacun d’entre eux. Plus d’informations sur les outils de Business Intelligence open source peuvent être trouvées dans cet article en anglais du site Internet OpenSource.com.

| Logiciels de BI | Extraction de données brutes | Tranformation de données brutes | Chargement de données transformées | OLAP | Data mining | Tableau de bord | Rapports |

|---|---|---|---|---|---|---|---|

| Pentaho DI | - | - | - | - | |||

| Talend OS | - | - | - | - | |||

| Jasper ETL | - | - | - | - | |||

| Pentaho Mondrian | - | - | - | - | |||

| Jedox | - | - | - | ||||

| BIRT | - | - | - | - | |||

| SQL Power Wabit | - | - | - | ||||

| KNIME | - | ||||||

| RapidMiner | |||||||

| Weka | - | - | |||||

| JasperSoft | |||||||

| Pentaho | |||||||

| SpagoBI |

Les programmes open source listés peuvent être assignés aux domaines de l’ETL, OLAP, data mining et du reporting selon les domaines d’application. En outre, il existe des solutions de BI intégrées couvrant tous les domaines répertoriées.

Solutions ETL

Les programmes open source Pentaho DI, Talend OS et Jasper ETL sont idéaux pour l’acquisition de données et pour une intégration dans un processus ETL (extraction, transformation, chargement).

- Pentaho DI : l’outil ETL Pentaho Data Integration (DI), également connu sous le nom de Kettle, fait partie de la suite BI de Penthao, mais peut aussi être utilisé comme application autonome dans les architectures d’entrepôt de données, indépendamment des autres composants Pentaho. L’outil d’acquisition et d’intégration de données dispose d’une interface utilisateur graphique qui permet aux utilisateurs sans connaissances en programmation de gérer les processus ETL. Pentaho DI offre un vaste choix de différents modules de processus avec lesquels les différentes étapes du processus ETL peuvent être définies. L’outil d’intégration de données prend en charge tous les systèmes de base de données courants. Les fichiers plats comme CSV, Excel, ou les fichiers texte peuvent aussi être utilisés comme sources de données. De plus, l’outil apporte des interfaces vers des suites BI propriétaires de SAS ou SAP ainsi que vers des logiciels d’analyse comme Google Analytics notamment.

- Talend OS : comparable à Pentaho DI, c’est l’outil ETL open source de l’éditeur de logiciels Talend. Talend Open Studio (OS) permet aussi aux utilisateurs de définir des processus d’acquisition et d‘intégration de données à l’aide de modules paramétrés (qui sont appelés « jobs »). Le programme offre des interfaces vers toutes les sources de données communes et diverses fonctions de transformations de données. Un éditeur de cartes permet aux utilisateurs de transférer des données brutes hétérogènes dans une structure cible prédéfinie. Comme avec Pentaho DI, les utilisateurs de Talend OS sans connaissances en programmation bénéficient d’une interface utilisateur graphique.

- Jasper ETL : Jasper ETL est le résultat d’une coopération entre les fabricants de logiciel Jaspersoft et Talend. L’outil ETL est essentiellement basé sur Talend OS, l’outil d’intégration de données open source leader sur le marché. Il est particulièrement adapté si d’autres produits BI de Jaspersoft sont utilisés dans le contexte de l’architecture DWH.

Applications OLAP

Les outils OLAP réputés sous licence open source sont Pentaho Mondrian et Jedox.

- Pentaho Mondrian : Mondrian est un serveur OLAP basé sur Java. Développé à l’origine comme un projet open source indépendant, Mondrian fait partie depuis 2006 de la suite BI de Pentaho. Les utilisateurs peuvent continuer à utiliser le logiciel en tant qu’application indépendante. Mondrian est également utilisé dans les solutions BI d’autres éditeurs de logiciels libres comme Jaspersoft. Les utilisateurs bénéficient d’un regroupement de ressources open source qui permet de réaliser des projets communs tels que le Mondrian Schema Workbench ou l’interface OLAP4J. Le projet Mondrian suit une technique basée sur structure relationnelle (ROLAP). La base de données est une base de données relationnelle, dont les tables sont organisées en étoile ou en flocon. L’accès prend la forme de requêtes multidimensionnelles (MDX), via XML pour l’analyse (XMLA) ou via l’interface Java OLAP4J. Le Mondrian Schema Workbench apporte aux utilisateurs une interface utilisateur graphique. Les schémas Mondrian peuvent être facilement développés et testés sur le bureau.

- Jedox : avec la suite BI du même nom, l’éditeur de logiciels Jedox offre une solution complète pour les applications de Business Intelligence et de gestion de la performance. Le composant central du logiciel est un puissant serveur OLAP en mémoire qui peut aussi être intégré dans d’autres environnements logiciels via des interfaces pour Java, PHP, C/C++ ou .NET. Pour les PME, utiliser Jedox est particulièrement adapté en raison de l’add-in Excel, qui peut aussi être utilisé afin de faire fonctionner le serveur OLAP à l’aide du célèbre logiciel tableau de Microsoft. En effet, les applications Office sont largement utilisées par les petites et moyennes entreprises, où elles constituent souvent la base de la gestion des données. L’intégration d’Excel réduit ainsi le temps et les efforts nécessaires notamment à la formation des employés.

Data mining

Des produits open source sont également disponibles pour les utilisateurs dans le domaine du data mining sous une licence open source. La BMWI recommande KNIME, RapidMiner et Weka.

- KNIME : KNIME est l’abréviation de « Konstanz Information Miner ». C’est un outil de data mining développé comme logiciel libre à l’université de Constance en Allemagne. Il offre aux utilisateurs, en plus de ses propres méthodes d’analyse, de nombreuses possibilités d’intégration pour différents algorithmes de data mining et d’apprentissage automatique (machine learning). Les différentes étapes de prétraitement de données (ETL), de la modélisation, de l’analyse et de la visualisation peuvent être définies via une interface utilisateur graphique en glissant et déposant les modules respectifs dans la zone de travail. KNIME.com, AG basée à Zurich, propose un téléchargement gratuit du logiciel. Si nécessaire, les utilisateurs peuvent aussi y obtenir un soutien technique professionnel et des services de consultation. Le programme écrit en Java est proposé sous la forme de plugins pour l’outil de programmation Eclipse (IDE).

- RapidMiner : la plateforme d’analyse RapidMiner de l’éditeur de logiciels du même nom offre aux utilisateurs un environnement intégré pour l’apprentissage automatique, le data mining, les analyses des tendances et les modèles de prévision dans un modèle open core. Le support couvre toutes les étapes du processus de data mining dont la préparation, la visualisation, la validation et l’optimisation des données. Les utilisateurs pour lesquels la version communautaire gratuite, avec un seul processeur logique et une portée d’analyse allant jusqu’à 10 000 enregistrements de données n’est pas suffisante, peuvent choisir la licence Entreprise payante. Le programme est écrit en Java, et offre une interface utilisateur graphique avec laquelle le workflow d’analyse peut être facilement défini et exécuté en quelques clics de souris.

- Weka : Weka (Waikato Environment for Knowledge Analysis) est un projet open source de l’université de Waikato en Nouvelle-Zélande. L’outil d’analyse apporte aux utilisateurs différents algorithmes dans le domaine de l’apprentissage automatique. Outre les méthodes classiques de data ming comme la classification, l’association ainsi que la régression ou l’analyse de cluster, Weka comporte divers modules de visualisation et de prétraitement des données. Le programme écrit en Java offre une interface utilisateur graphique. Les fonctionnalités du logiciel peuvent s’exécuter aussi via les lignes de commande. Si besoin, Weka peut être intégré à vos propres solutions logicielles via une interface Java.

Systèmes de reporting

Les outils de reporting open-source recommandés sont BIRT et SQL Power Wabit. Outre les rapports mensuels, trimestriels et annuels classiques, ces rapports offrent aussi des fonctions d’analyse ad hoc permettant de fournir des informations pertinentes en temps réel.

- BIRT : BIRT (Business Intelligence and Reporting Tools) est un projet open source de la fondation à but non lucratif Eclipse Foundation, qui fournit des fonctionnalités de reporting BI pour « clients riches (RCP) » et applications Web. Le logiciel est adapté aux applications basées sur Java et couvre un large éventail de visualisation et de rapports de données. Les rapports BIRT sont créés via une interface utilisateur graphique basée sur l’outil de programmation open source Eclipse et sauvegardés sous forme de fichiers XML.

- SQL Power Wabit : avec l’outil de reporting SQL Power Wabit, les utilisateurs peuvent créer des rapports basés sur des requêtes classiques de base de données. Les cubes OLAP ne sont pris en charge que s’il existe une description de la structure de données. L’outil prend en charge les rapports standards, les requêtes ad hoc, les pages de synthèse définies par l’utilisateur et les opérations de recherche dans le cadre du traitement analytique en ligne. Avec des fonctions comme le contrôle par glisser-déposer, la mise à jour des rapports de résultats en temps réel, la recherche globale et un éditeur WYSIWYG pour la rédaction de rapports, SQL Power Wabit convient également aux utilisateurs qui n’ont pas de connaissances en SQL. Grâce à cela, des rapports détaillés peuvent être facilement créés et si nécessaire, adaptés individuellement en ce qui concerne la police, les couleurs et la mise en page.

Solutions de BI intégrées

En plus des suites de Business Intelligence d’éditeurs réputés comme SAP, Oracle, IBM, SAS, HP ou Microsoft, il existe aussi des projets logiciels sur le marché open source qui apportent aux utilisateurs des solutions d’entreposage de données sous forme de collections de programmes intégrés. Pentaho CE, Jaspersoft et SpagoBI sont pour cela recommandés.

- Pentaho Community Edition (CE) : en plus des développements internes, la suite Pentaho BI comporte aussi des projets open source existants qui ont été progressivement achetés puis intégrés dans le portefeuille de produits. Le projet se concentre sur l’intégration des données et l’automatisation des rapports. La collection du programme comprend :

- Pentaho Business Analytics Platform : la plateforme Business Analytics est une application Web qui permet aux utilisateurs de regrouper toutes les informations dans une plateforme centrale.

- Pentaho Data Integration : Pentaho DI se réfère à l’outil ETL décrit ci-dessus.

- Pentaho Report Designer (PRD) : PRD est un développement du projet JFreeReport. La solution de reporting open source prend en charge différents formats de sortie comme PDF, Excel, HTML, Text, Rich-Text-File, XML et CSV.

- Pentaho Marketplace : le Marketplace permet aux utilisateurs d’ajouter des plugins à la plateforme Pentaho en un simple clic.

- Pentaho Aggregation Designer (PAD) : avec PAD, les utilisateurs peuvent créer et optimiser le contenu des bases de données. Le cœur de l’outil est le serveur OLAP Mondrian.

- Pentaho Schema Workbench (PSW) : PSW est une interface de conception graphique qui offre la possibilité aux utilisateurs de créer et de tester les schémas pour les cubes OLAP Mondrian.

- Pentaho Metadata Editor (PME) : PME est utilisé pour décrire dans le détail les structures de données sous-jacentes à l’aide d’un fichier XML.

- Pentaho Business Analytics Platform : la plateforme Business Analytics est une application Web qui permet aux utilisateurs de regrouper toutes les informations dans une plateforme centrale.

Pentaho Enterprise Edition (EE) est une version payante de la suite de BI avec des fonctionnalités étendues et un support professionnel.

- Jaspersoft : Jaspersoft propose diverses applications DWH dans une solution de BI intégrée. La collection du programme comprend donc :

- JasperReports Server : le serveur JasperReports est un serveur de rapports qui apporte une fonctionnalité OLAP par l’intermédiaire d’un serveur Mondrian ajusté.

- JasperReports Library : Jaspersoft fournit une bibliothèque Java pour la création de rapports.

- Jaspersoft Studio : avec Jaspersoft Studio, la suite de BI fournit un éditeur de rapports.

- Jaspersoft ETL : l’outil ETL basé sur Talend OS déjà décrit ci-dessus.

- Mobile BI : Mobile BI est une application native pour iPhone et Android qui apporte un accès mobile aux rapports et tableaux de bord.

Jaspersoft est aussi disponible avec une gamme étendue de fonctions dans une version commerciale payante.

- SpagoBI : contrairement à Penthao et Jaspersoft, qui commercialisent leurs produits avec un système de double licence, SpagoWorld offre sa suite de BI exclusivement sous la forme de solution open source. Les entreprises ont cependant la possibilité d’utiliser une configuration et une adaptation professionnelle du logiciel via un service payant. La collection du programme comprend les éléments suivants :

- SpagoBI Server : le cœur de la suite de BI open source est le serveur SpagoBI, qui fournit tous les outils et fonctionnalités d’analyse.

- SpagoBI Studio : SpagoBI Studio est un environnement de développement intégré.

- SpagoBI Meta : SpagoBI Meta apporte aux utilisateurs un environnement de gestion des métadonnées.

- SpagoBI SDK : avec SpagoBI SDK, la suite Spago BI dispose d’une couche d’intégration qui permet d’intégrer différents outils externes, tels que Talend OS (ETL), Jedox ou Mondrian (OLAP), Weka ou R (datamining) ainsi que BIRT ou JasperReports Library (reporting).

Archivage des données

Les utilisateurs ont également diverses alternatives aux systèmes de gestion de bases de données propriétaires tels que Microsoft SQL Server, IBM DB2 ou les solutions d’Oracle et Teradata disponibles en tant que projets de logiciels libres dans le domaine de la gestion des données. Les principaux magasins de données sont les systèmes de bases de données relationnelles MySQL et MariaDB ou le système de gestion de base de données relationnel/objet PostgreSQL. Le dernier est publié par Pivotal sous le nom de Greenplum Database en tant que développement optimisé, en particulier pour les architectures d’entrepôt de données sous licence open source.

Conclusion : l’entreposage de données dans les entreprises de taille moyenne

Le data warehousing est arrivé sur le marché dit intermédiaire. Le marché des solutions de BI et des systèmes de data warehouse offre, en plus des solutions Entreprise payantes, un large éventail de projets open source utilisables. Pour les petites et moyennes entreprises, l’obstacle financier associé à l’analyse de données volumineuses diminue ainsi.

Il est recommandé aux petites et moyennes entreprises de se concentrer d’abord sur le reporting lors de l’introduction de solutions de BI. Les entrepreneurs obtiennent une valeur ajoutée en combinant les données existantes avec des dépenses simples. Si des lacunes dans la base de données deviennent apparentes au cours de l’analyse, la prochaine étape devrait être de réorganiser la collecte de données à l’aide des outils ETL ou OLAP présentés ici. L’intégration d’une architecture d’entrepôt de données (DWH) dans l’infrastructure informatique respective est complétée par des outils de data mining, qui peuvent identifier de nouvelles tendances et des connexions croisées grâce à des analyses plus poussées (par exemple, des analyses de panier d’achat) et apporter ainsi une contribution cruciale pour la prise de décision stratégique.

Les entreprises de taille moyenne qui envisagent de créer un entrepôt de données devraient s’attacher dès le départ à mettre en œuvre la stratégie de BI en se conformant et en respectant les règles en matière de protection des données.