Fog computing : définition et explications

L’Internet des Objets (IoT pour Internet of Things) redéfinit le paysage informatique mondial et est déjà reconnu comme une technologie clé dans de nombreux projets d’avenir. Toutefois, l’architecture traditionnelle de l’IoT, caractérisée par la centralisation et le traitement des données, ne peut pas évoluer à l’infini, notamment en raison des limites de la bande passante. Dans le cadre du fog computing, des solutions innovantes sont développées pour résoudre de tels problèmes lors de la mise en œuvre de l’IoT.

- vCPU aux coûts avantageux et cœurs dédiés performants

- Sans engagement pour plus de flexibilité

- Assistance par des experts 24h/24 et 7j/7 incluse

Qu’est-ce que le fog computing ? Définition

On désigne par « fog computing » une technologie Cloud dans laquelle les données générées par les terminaux ne sont pas directement téléchargées dans le Cloud, mais sont au préalable prétraitées dans des mini-centres de calcul décentralisés (Fog Nodes). Le concept inclut une structure réseau qui s’étend des points les plus périphériques du réseau, où les données sont générées par des dispositifs et objets connectés, jusqu’au terminal de données central dans le Cloud public ou dans un data center privé (Cloud privé).

Le « fogging » (on trouve également les termes de fog networking ou d’edge computing), comme on l’appelle, vise à raccourcir les voies de communication et à réduire le débit de données sur des réseaux tiers. Les fog nodes forment une couche intermédiaire dans le réseau, qui détermine les données à traiter localement et celles transmises au Cloud ou à un data center central en vue d’une analyse ou d’un traitement ultérieur.

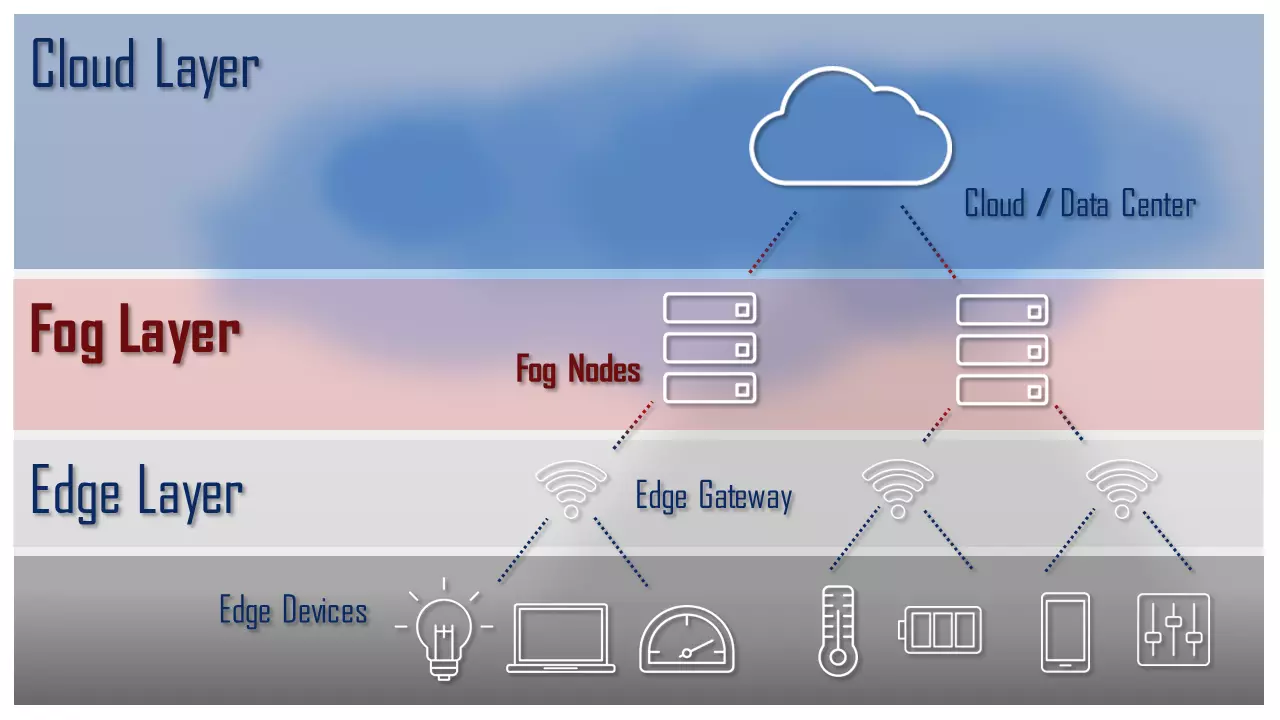

La figure suivante montre une représentation schématique des trois couches d’une architecture de fog computing :

- Couche périphérique (edge layer) : la couche périphérique comprend tous les dispositifs « intelligents » (dispositifs périphériques) d’une architecture IoT Les données générées au niveau de la couche périphérique sont soit traitées directement sur le périphérique, soit transmises à un serveur (fog node) de la couche fog.

- Couche fog (fog layer) : la couche fog comprend un certain nombre de serveurs performants qui reçoivent les données de la couche périphériques, les prétraitent, et les téléchargent dans le Cloud si nécessaire.

- Couche Cloud (Cloud layer): la couche Cloud est le terminal de données central d’une architecture de Cloud computing.

Une architecture de référence pour les systèmes fog a été développée dans le cadre du consortium OpenFog (désormais IIC pour Industrial IoT Consortium). Vous trouverez d’autres informations sur le site Web de l’IIC.

Différenciation avec le Cloud computing

Le fog computing se distingue avant tout du Cloud computing par le lieu où les ressources sont mises à disposition et où les données sont traitées. Le Cloud computing se fait généralement dans des data centers centralisés. Des ressources comme la puissance de traitement ou la capacité de stockage sont regroupées au niveau de serveurs principaux et utilisées par les clients via le réseau. La communication entre deux périphériques ou plus s’effectue donc toujours via un serveur en arrière-plan.

Une telle architecture atteint ses limites avec des concepts tels que « l’usine intelligente », où les données doivent être échangées en permanence entre d’innombrables terminaux. Le fog computing recourt ici à un traitement intermédiaire proche de la source de données, afin de réduire le débit de données vers le centre de calcul.

Différenciation avec l’edge computing

Le débit de données des architectures IoT à grande échelle n’est pas le seul inconvénient du Cloud computing, il y a aussi le problème de la latence. Le traitement de données centralisé est à chaque fois associé au retard dû à des chemins de transmission longs. Les terminaux et les capteurs doivent toujours s’adresser au serveur du centre de calcul pour communiquer entre eux, attendre le traitement externe de la demande ainsi que la réponse. Ces délais dus à la latence deviennent un problème, notamment dans les processus de fabrication basés sur l’IoT, pour lesquels il faut assurer le traitement de l’information en temps réel, afin que les machines puissent réagir immédiatement aux incidents.

L’edge computing propose une solution à ce problème de latence. C’est un concept qui, dans le cadre du fog computing, propose un traitement des données non seulement décentralisé, mais directement dans le terminal et donc à la périphérie (edge) du réseau. Chaque « dispositif intelligent » est équipé de son propre microcontrôleur permettant le traitement de données de base et la communication avec d’autres appareils et capteurs de l’IoT. Cela réduit non seulement la latence, mais aussi le débit de données au niveau du data center central.

Le fog computing et l’edge computing sont étroitement liés, bien qu’ils présentent des différences essentielles dans la manière et le moment où les données sont traitées. Dans l’edge computing, les données sont traitées directement à la source et généralement transmises immédiatement. En revanche, le fog computing consiste à rassembler et à traiter les données brutes provenant de divers sources au sein d’un centre de calcul intermédiaire. Cette approche permet d’éviter la transmission de données ou de résultats non pertinents au centre de calcul central. Le choix entre l’edge computing, le fog computing, ou une combinaison des deux, dépend du domaine d’application spécifique.

Les avantages du fog computing

Le fog computing offre des solutions à divers problèmes des infrastructures informatiques de type Cloud. L’accent est mis sur les approches qui promettent des voies de communication courtes et minimisent le téléchargement vers le Cloud. Voici une liste des principaux avantages :

- Moins de trafic réseau : le fog computing réduit le trafic entre les dispositifs IoT et le Cloud.

- Réduction des coûts liés à l’utilisation de réseaux tiers : les opérateurs de réseau font payer cher le téléchargement rapide vers le Cloud ; une partie de ces coûts peut être économisée grâce au fog computing.

- Disponibilité hors ligne : les appareils IoT sont également disponibles hors ligne quand ils sont intégrés dans une architecture de fog computing.

- Latence réduite : le fog computing raccourcit les voies de communication et accélère ainsi les processus automatisés d’analyse et de décision.

- Sécurité des données : quand on a recours au fog computing, le prétraitement des données de l’appareil a lieu sur le réseau local. Cela permet une implémentation dans laquelle les données sensibles restent dans l’entreprise ou peuvent être chiffrées ou rendues anonymes avant d’être téléchargées sur le Cloud.

Les inconvénients du fog computing

Le traitement décentralisé dans des petits data centers présente également des inconvénients. Ceux-ci sont avant tout le fait des coûts de maintenance et d’administration d’un système distribué.

- Coûts de matériel plus élevés : les terminaux et capteurs IoT de l’architecture fog computing doivent être équipés d’une unité de traitement supplémentaire pour permettre le traitement de données local et la communication entre appareils.

- Augmentation des besoins de maintenance : le traitement décentralisé des données implique des besoins accrus de maintenance. La raison en est que les éléments de traitement et de stockage sont répartis sur l’ensemble du réseau et que, contrairement aux solutions Cloud, ils ne peuvent être ni maintenus ni administrés de manière centralisée.

- Défis supplémentaires en sécurité réseau : le fog computing est sensible aux attaques de type « homme du milieu » (ou intercepteur).