Qu’est-ce que l’edge computing ?

Dans le monde de l’Internet des objets (IoT), les machines génèrent en permanence des données devant être stockées et évaluées en temps réel pour des applications critiques. L’edge computing évalue ces données directement à la source et introduit ainsi un changement de paradigme dans l’univers du Cloud computing.

L’edge computing, c’est quoi ?

L’edge computing se définit comme une architecture informatique destinée aux environnements IoT, dans laquelle les ressources informatiques, la capacité de stockage et la puissance de calcul sont maintenues au plus près des équipements terminaux et des capteurs qui génèrent les données. Le concept représente ainsi une alternative aux solutions de Cloud ordinaires avec des serveurs centralisés.

Le mot edge vient de l’anglais et signifie bord ou périphérie. Ce terme fait allusion au fait que le traitement des données ne se fait plus dans le Cloud, mais il est décentralisé, en périphérie du réseau. L’edge computing peut ainsi offrir une option que le Cloud n’est pas capable de proposer, à savoir des serveurs capables d’interpréter sans délai les données de masse générées par des usines, des réseaux de distributions ou des systèmes de circulation « intelligents », et de prendre immédiatement les mesures nécessaires en cas d’incidents.

Présentation des fondamentaux de l’edge computing

L’edge computing s’appuie sur d’anciennes technologies dans un format compact, mais employées sous une nouvelle dénomination. Voici un aperçu des éléments de base de l’edge computing.

- Edge : dans le jargon informatique, « edge » désigne la périphérie du réseau. Quant à savoir quels seront les éléments implantés en périphérie du réseau, cela dépendra de la configuration mise en place. Dans des réseaux de télécommunication, ce sera par exemple un téléphone portable qui représentera la périphérie du réseau ; et dans un système de voitures autonomes interconnectées, chaque véhicule.

- Edge device : on entend par « edge device » tout appareil situé en périphérie de réseau, et qui génère des données. Les sources de données possibles sont par exemple des capteurs, des machines, des véhicules ou tous les autres appareils intelligents dans un environnement IoT, comme des lave-linge, des détecteurs d’incendie, des ampoules ou des thermostats pour radiateur.

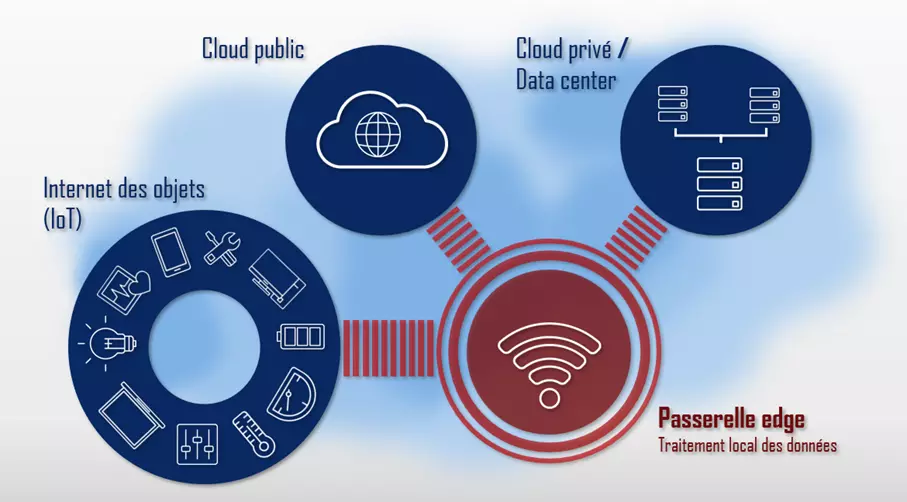

- Passerelle edge : la passerelle edge est une instance de calcul implantée à la transition entre deux réseaux. Dans des environnements IoT, les passerelles edge sont utilisées comme nœuds entre l’Internet des objets et le réseau central.

L’edge computing vs le fog computing

L’approche visant à étendre le Cloud autour des instances de calcul n’est pas une nouveauté. En 2014 déjà, le groupe américain Cisco a créé le terme marketing, baptisé fog computing. Les données générées dans des environnements IoT ne sont ici pas directement envoyées dans le Cloud. Elles sont d’abord collectées dans des fog Notes, où elles sont interprétées avant d’être sélectionnées pour d’autres formes de traitement.

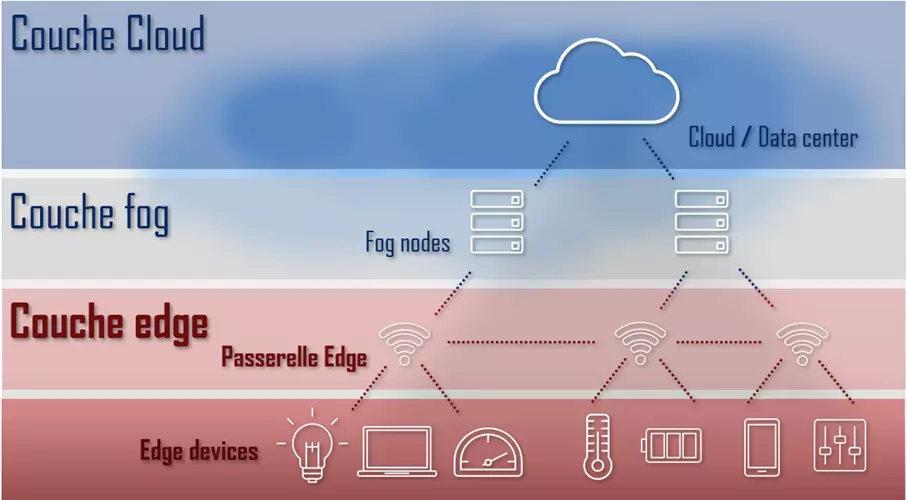

L’edge computing est aujourd’hui considéré comme faisant partie du fog computing, où les ressources informatiques, comme la puissance de calcul et la capacité de stockage sont rapprochées au mieux des équipements IoT, en périphérie du réseau. On peut parfaitement envisager une combinaison des deux concepts. Le schéma ci-dessous montre une telle architecture avec une couche Cloud, fog et edge.

Les architectures de référence pour les environnements de fog computing et edge computing sont développées dans le cadre de l’Open Fog Consortium, un lieu de rencontre entre l’industrie et la science.

Pourquoi l’edge computing ?

Aujourd’hui, ce sont les grands centres de données qui supportent l’essentiel du volume des données générées par Internet. Les sources de données sont pourtant très souvent mobiles de nos jours, et trop éloignées des gros ordinateurs centraux pour pouvoir garantir un délai de latence satisfaisant. Ce facteur pose problème, en particulier pour les applications critiques comme l’apprentissage automatique et la maintenance prévisionnelle, deux concepts de base du projet allemand Industrie 4.0.

La maintenance prédictive (ou maintenance prévisionnelle) a pour but de révolutionner la maintenance et l’entretien des sites de production dans le futur. Ce nouveau concept de maintenance souhaite identifier les risques de panne au moyen de systèmes de surveillance intelligents, avant qu’un véritable défaut ne survienne.

L’edge computing ne vient donc pas remplacer le Cloud, mais il le complète avec les fonctionnalités suivantes :

- Saisie et agrégation des données : l’edge computing mise sur un enregistrement des données au plus près de la source, y compris le prétraitement et la sélection du jeu de données. Le téléchargement des données vers le Cloud ne se fait alors que si les informations ne peuvent pas être traitées en mode local, si des analyses plus poussées doivent être effectuées ou s’il y a un besoin d’archiver certaines informations.

- Saisie des données en mode local : en cas de gros volume de données, il n’est généralement pas possible de procéder à un transfert en temps réel de l’ordinateur central vers le Cloud. On évite ce problème si on opte pour un traitement décentralisé de ces données en périphérie du réseau. Dans un tel scénario, les passerelles edge font office de serveurs de réplication dans un réseau de diffusion de contenu.

- Monitoring piloté par intelligence artificielle : l’edge computing permet une surveillance continue des appareils connectés. Combiné à des algorithmes d’apprentissage automatique, il permet de contrôler l’état des dispositifs en temps réel.

- Communication M2M : l’edge computing est souvent utilisé en relation avec la communication M2M afin de permettre une communication directe entre les appareils en réseau.

Le schéma suivant illustre le principe de base d’une architecture Cloud décentralisée, dans laquelle les passerelles de périphérie font office d’instance intermédiaire entre un ordinateur central dans le Cloud et les appareils IoT en périphérie du réseau.

Domaines d’application pour des architectures d’edge computing

Les domaines d’application pour l’edge computing viennent généralement de l’environnement IoT. Un facteur de croissance important de la technologie de l’edge computing est le besoin croissant de systèmes de communication fonctionnant en temps réel. Le traitement décentralisé des données est une technologie clé pour les projets suivants :

- La communication de véhicule à véhicule : l’edge computing est important pour les systèmes d’alerte précoce basés sur le Cloud ou les moyens de transport autonomes.

- Le réseau électrique intelligent : grâce à des systèmes énergétiques décentralisés, le réseau électrique doit s’adapter aux variations de puissance. Les données transportées vers les producteurs permettent de réagir en temps réel aux changements de consommation.

- Le Smart Factory : des installations de production et des systèmes logistiques qui s’organisent eux-mêmes peuvent être réalisés grâce à l’edge computing.

Les avantages de l’edge computing

Le tableau ci-dessous vous présente les avantages d’une architecture d’edge computing, comparée à un environnement Cloud traditionnel.

- Traitement des données en temps réel : dans les architectures d’edge computing, les unités de calcul sont rapprochées au mieux des sources de données, favorisant une communication en temps réel. On évite ainsi le problème récurrent de latence rencontré avec les solutions de Cloud plus classiques.

- Débit utile réduit : l’edge computing privilégie un traitement des données en local au niveau de passerelles edge. Seules les données qui ne peuvent pas être traitées localement, ou qui doivent être mises en lignes, sont téléchargées dans le Cloud.

- La sécurité des données : avec une solution d’edge computing, la majeure partie des données reste dans le réseau local. Dans une telle configuration, les entreprises auront plus de facilité à se conformer aux exigences de conformité.

Les inconvénients de l’edge computing

Malgré ses nombreux avantages, l’edge computing présente également des inconvénients qui doivent être pris en compte :

- Des structures de réseau plus complexes : un système de répartition est bien plus compliqué qu’une architecture Cloud centralisée. Un environnement edge computing est un ensemble hétérogène de plusieurs composants de réseau, venant en partie de divers fabricants, et qui communiquent les uns avec les autres grâce à un grand nombre d’interfaces.

- Les frais d’acquisition pour du matériel edge : les architectures de Cloud se distinguent avant tout par le fait qu’il y a beaucoup moins d’équipement matériel à installer localement.

- Un niveau de maintenance plus élevé : un système décentralisé, composé de plusieurs nœuds de calcul, nécessite plus d’entretien et d’administration qu’un centre de données.