Les token IA : définition, fonctionnement et calcul

Les tokens (ou jetons) IA représentent la plus petite unité linguistique dont les modèles IA ont besoin pour traiter et interpréter le texte. La tokenisation permet de décomposer le langage en ces éléments, ce qui constitue la base de l’analyse et de la génération de textes. Des outils comme OpenAI Tokenizer permettent de d’identifier rapidement les tokens d’un texte.

Qu’est-ce qu’un token IA ?

Un AI token, également appelé jeton IA en français, représente la plus petite unité de données des modèles d’IA tels que ChatGPT, LLama2 et Copilot. Les tokens sont l’élément le plus important pour le traitement, l’interprétation et la génération de texte, car ce n’est qu’en décomposant un texte en tokens que l’intelligence artificielle peut comprendre le langage et fournir des réponses appropriées aux demandes des utilisateurs. Les tokens IA peuvent représenter aussi bien des mots isolés ou des parties de mots que des signes de ponctuation et des emojis.

Le nombre de jetons IA qui composent un texte dépend de différents facteurs. Outre la longueur du texte, la langue et le modèle d’IA utilisés sont également importants dans ce contexte. Si vous utilisez un accès API tel que ChatGPT API, le nombre de jetons détermine également les coûts. Dans la plupart des cas, les applications IA facturent généralement en fonction du nombre de tokens générés ou traités.

- Créez votre site Web en un temps record

- Boostez votre activité grâce au marketing par IA

- Gagnez du temps et obtenez de meilleurs résultats

Comment fonctionne la tokenisation ?

La tokenisation est le processus par lequel un modèle d’IA convertit un texte en jetons. Cette étape est nécessaire, car les Large Language Models (LLM) ont besoin de la langue naturelle dans une forme que la machine peut analyser. La tokenisation constitue donc la base de l’interprétation de texte, de la reconnaissance de formes et de la création de réponses. Sans ce processus de transformation, l’intelligence artificielle ne serait pas en mesure de saisir les rapports de signification et de relation. La conversion du texte en jetons se compose de plusieurs étapes et se déroule de la manière suivante :

- Normalisation : dans un premier temps, le modèle d’IA transforme le texte en une forme normalisée, afin d’en réduire la complexité et la variance. Au cours de la normalisation, le texte complet est converti en minuscules, les caractères spéciaux sont supprimés et les mots sont parfois limités à une forme de base.

- Découpage du texte en tokens : l’intelligence artificielle décompose le texte en tokens, c’est-à-dire en unités linguistiques plus petites. La manière dont les blocs de texte sont divisés en détail dépend de la complexité et du mode d’entraînement du modèle. La phrase « L’IA révolutionne les études de marché » comporte 9 tokens pour GPT-4o, 11 tokens pour GPT-4 et 3.5, et 15 pour GPT-3.

- Affectation de valeurs numériques : le modèle d’IA attribue à chaque jeton IA une valeur numérique, appelée token ID. Les ID sont en quelque sorte le vocabulaire de l’IA, qui contient tous les tokens connus par le modèle.

- Traitement des tokens IA : le modèle linguistique analyse la relation entre les tokens afin d’identifier des modèles et d’établir des prédictions ou des réponses. Celles-ci sont générées sur la base de probabilités. Le modèle IA examine les informations contextuelles et détermine les jetons IA sur la base des précédents.

- Conforme au RGPD et hébergée en toute sécurité en Europe

- Modèles d'IA les plus puissants

- Open source, sans vendor lock-in

Comment calculer les tokens d’un texte ?

Il est possible de comprendre comment les tokens sont calculés par l’intelligence artificielle à l’aide de ce que l’on appelle les tokenizers, qui décomposent les textes en leurs plus petites unités de traitement. Ils fonctionnent selon des algorithmes spécifiques qui s’orientent sur les données d’entraînement et l’architecture du modèle d’IA. Outre l’affichage du nombre de tokens, de tels outils peuvent également fournir des informations détaillées sur chaque token, comme leur ID (identifiant numérique). Cela permet non seulement de mieux calculer les coûts, mais aussi d’optimiser les textes pour réduire les coûts ou améliorer la compréhension par le modèle.

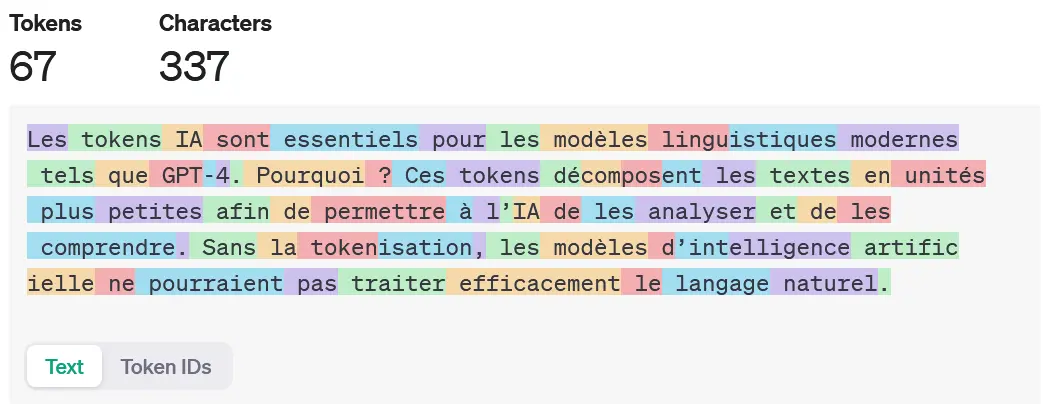

Un exemple de tokenizer librement accessible est le OpenAI Tokenizer, qui est conçu pour les modèles ChatGPT actuels. Après avoir copié ou tapé le texte souhaité dans le champ de saisie, l’application vous présente les différents tokens IA en mettant en évidence les unités avec un code couleur.

La longueur maximale du texte dépend toujours de la limite de tokens du modèle concerné. GPT-4, par exemple, peut traiter jusqu’à 32 768 tokens par requête.

Tokens IA et tokenisation : exemple pratique

Pour avoir une meilleure idée de ce qu’est la tokenisation, nous avons rédigé un court texte d’exemple :

Les tokens IA sont essentiels pour les modèles linguistiques modernes tels que GPT-4. En effet, ces tokens décomposent les textes en unités plus petites afin de permettre à l’IA de les analyser et de les comprendre. Sans la tokenisation, les modèles d’intelligence artificielle ne pourraient pas traiter efficacement le langage naturel.

Le modèle GPT-4o décompose ce texte de 337 caractères en 67 tokens de la manière suivante :