Crawler : comment ces robots d’indexation optimisent Internet ?

Les crawlers sont la raison pour laquelle les moteurs de recherche tels que Google, Bing, Yahoo et DuckDuckGo fournissent toujours de nouveaux résultats de recherche actualisés. À la façon d’une araignée, ces bots parcourent le Web, collectent des informations et les enregistrent dans des index. Mais quelles sont les autres utilisations des Web crawlers et quels types de crawlers existe-t-il dans le World Wide Web ?

Qu’est-ce qu’un crawler ?

Les crawlers sont des bots parcourant Internet à la recherche de données. Ils analysent les contenus et enregistrent les informations dans des bases de données et des index pour améliorer la performance des moteurs de recherche. Par ailleurs, ils collectent des données de contact et de profil à des fins marketing.

Comme les crawlers parcourent le Web – et toutes ses ramifications – à la recherche d’informations à la façon d’une araignée, ils sont également désignés sous le nom de « spider bots ». Ils sont cependant aussi connus sous les noms de « search bots », « Web crawlers » et « robots d’indexation ». Basé sur le langage de programmation PERL, le premier robot d’indexation s’appelait World Wide Web Wanderer (abrégé en : WWW Wanderer). À partir de 1993, WWW Wanderer a mesuré la croissance d’Internet, encore récent à l’époque, et a enregistré les données collectées dans le premier index Internet Wandex.

Le WWW Wanderer a été suivi en 1994 par le premier navigateur du nom de Webcrawler, qui est aujourd’hui le plus ancien moteur de recherche encore en activité. Grâce aux robots d’indexation, les moteurs de recherche peuvent entretenir leurs bases de données en ajoutant automatiquement à l’index de nouveaux contenus Web et sites Internet, en l’actualisant et en effaçant les contenus n’évoluant plus.

Les crawlers sont tout particulièrement essentiels pour l’optimisation des moteurs de recherche (SEO). Pour les entreprises, il est essentiel de se familiariser avec les différents types de Web crawlers et leurs fonctionnalités pour proposer des contenus optimisés en SEO.

Comment fonctionne un crawler ?

À l’instar des social bots et des chatbots, les robots d’indexation sont également composés d’un code avec des algorithmes et des scripts qui attribue des tâches et des commandes précises. Le crawler répète les fonctions définies dans le code de façon autonome et continue.

Les robots d’indexation se déplacent sur le Web à l’aide des hyperliens des sites Internet déjà existants. Pour analyser de nouveaux sites Internet, ils évaluent les mots-clés et les hashtags, indexent les contenus et les URL de chaque site Internet, copient les pages Web et ouvrent toutes les URL trouvées ou uniquement une sélection d’URL. Par ailleurs, les crawlers vérifient l’actualité des liens et des codes HTML.

À l’aide d’outils d’analyse Web spécifiques, les Web crawlers peuvent analyser les informations telles que les consultations de pages et les liens ainsi que collecter des données ou les comparer de façon ciblée (par exemple pour les portails de comparaison) dans le cadre d’un data mining.

Quels types de crawlers existe-t-il ?

Il existe différents types de Web crawlers qui se distinguent par leur focalisation et leur portée.

Les robots d’indexation des moteurs de recherche

Les Web crawlers les plus anciens et les plus souvent utilisés sont les searchbots de Google ou d’autres moteurs de recherche comme Yahoo, Bing ou DuckDuckGo. Ils consultent, collectent et indexent le contenu du Web afin d’optimiser la portée et la base de données des moteurs de recherche. Les noms des Web crawlers les plus connus sont :

- GoogleBot (Google) ;

- Bingbot (Bing) ;

- Slurpbot (Yahoo) ;

- DuckDuckBot (DuckDuckGo) ;

- Baiduspider (Baidu) ;

- Yandex Bot (Yandex) ;

- Sogou Spider (Sogou) ;

- Exabot (Exalead) ;

- Facebot (Facebook) ;

- Alexa Crawler (Amazon).

Crawlers de sites Web personnels

Simples dans leurs fonctionnalités, ces petits crawlers peuvent être utilisés par des entreprises individuelles pour réaliser des tâches spécifiques. De cette façon, elles peuvent par exemple surveiller la fréquence de certains mots-clés ou l’accessibilité de certaines URL.

Crawlers de sites Web commerciaux

Les crawlers commerciaux sont des solutions logicielles complexes d’entreprises proposant les Web crawlers à titre d’outils payants. Ils offrent davantage de services et fonctionnalités et permettent aux entreprises d’économiser le temps et l’argent nécessaires au développement de leur propre crawler.

Crawlers de sites Web sur le cloud

On trouve également des robots d’indexation de sites Web enregistrant les données sur un cloud au lieu d’un serveur local et généralement commercialisés sous forme de services par des entreprises informatiques. Du fait de leur indépendance vis-à-vis des ordinateurs locaux, les outils d’analyse et les bases de données peuvent être utilisés par n’importe quel appareil à l’aide des données d’accès correspondantes et leur application est modulable.

Crawlers de sites Web de bureau

Il est également possible d’exécuter de petits Web crawlers sur un PC ou un ordinateur portable personnel. Généralement, ces robots d’indexation à l’utilité très limitée mais peu coûteux peuvent uniquement analyser de petites quantités de données et de sites Internet.

Comment procèdent les crawlers en pratique ?

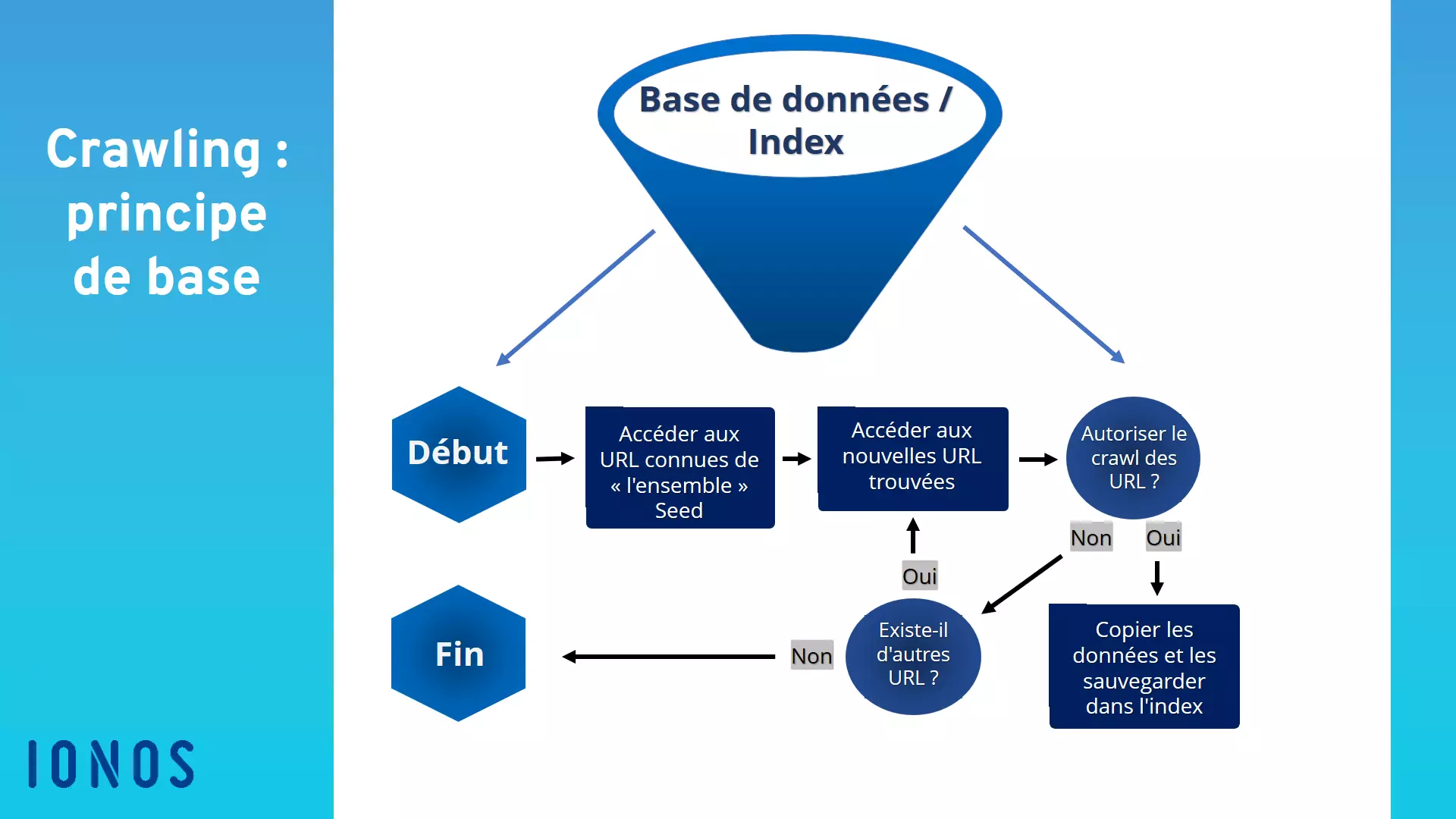

La procédure concrète suivie par un Web crawler comporte plusieurs étapes :

- crawl frontier : les moteurs de recherche définissent dans une structure de données appelée Crawl frontier si le robot d’indexation doit rechercher de nouvelles URL via des sites Internet connus et indexés ainsi que via des liens indiqués dans les plans de site ou si seuls des sites Internet et des contenus spécifiques doivent être explorés ;

- ensemble « seed » : les crawlers reçoivent un « ensemble seed » du moteur de recherche ou du donneur d’ordre. L’ensemble seed est une liste d’adresses Web et d’URL connues ou à explorer. Cet ensemble est basé sur les indexations, les bases de données et les plans de sites utilisés jusqu’à présent. Les crawlers parcourent cet ensemble jusqu’à ce qu’ils atteignent des boucles ou des liens morts. ;

- complément de l’index : en analysant le seed, les crawlers peuvent évaluer de nouveaux contenus Web et les ajouter à l’index. Ils actualisent les anciens contenus ou suppriment de l’index les URL et les liens lorsqu’ils n’existent plus ;

- fréquence du crawling : bien que les crawlers parcourent le Web sans interruption, les programmeurs peuvent déterminer à quelle fréquence ils devront visiter et analyser les URL. Pour ce faire, ils analysent la performance des pages, la fréquence des mises à jour et le trafic de données. En se basant sur ces données, les programmeurs définissent la demande en indexation ;

- gestion de l’indexation : les administrateurs des sites Internet peuvent exclure les visites de leur site Internet par les crawlers de façon ciblée. Cette exclusion est permise par des protocoles robots.txt ou des balises HTML nofollow. Lors de la consultation d’une URL, les robots d’indexation reçoivent ainsi l’instruction d’éviter un site Internet ou d’analyser uniquement les données de façon limitée.

Quels sont les avantages d’un robot d’indexation ?

Avantageux et efficace : les Web crawlers assurent des tâches d’analyse chronophages et coûteuses et peuvent scanner, analyser et indexer le contenu du Web de façon plus rapide, avantageuse et complète que les êtres humains.

Une utilisation simple et une vaste portée : les robots d’indexation peuvent être implémentés rapidement et simplement et garantissent une collecte et une analyse des données complète et continue.

Amélioration de la réputation en ligne : les crawlers permettent d’optimiser votre marketing en ligne en analysant et en se focalisant sur votre propre clientèle. D’autre part, les crawlers peuvent améliorer la réputation en ligne d’une entreprise en enregistrant les modèles de communication sur les réseaux sociaux.

Publicité ciblée : le data mining et une publicité ciblée permettant de toucher des groupes de clients spécifiques. Les sites Internet avec une fréquence de crawling élevée apparaissent plus haut dans les moteurs de recherche et sont davantage consultés.

Analyse des données d’entreprise et des données client : grâce aux robots d’indexation, les entreprises peuvent évaluer et analyser les données des clients et des entreprises disponibles en ligne ainsi que les utiliser pour leur marketing et leur stratégie d’entreprise.

Optimisation SEO : en analysant les termes de recherche et les mots-clés, il est possible de définir des mots-clés focus limitant la concurrence et augmentant les consultations du site.

D’autres domaines d’application sont :

- la surveillance continue de systèmes afin de trouver des points faibles ;

- l’archivage d’anciens sites Internet ;

- la comparaison de sites Internet mis à jour avec d’anciennes versions ;

- la détection et la suppression de liens morts ;

- l’examen du volume de recherche par mot-clé ;

- la détection de coquilles et d’autres contenus erronés.

Comment augmenter la fréquence de crawling d’un site Internet ?

Si vous souhaitez que votre site Internet apparaisse le plus haut possible dans les moteurs de recherche et soit régulièrement visité par les Web crawlers, vous devriez faciliter autant que possible l’accès des bots à votre site Internet. Les sites permettant une fréquence de crawling élevée bénéficient d’une priorité plus importante dans les moteurs de recherche. Les facteurs suivants sont décisifs pour qu’un site Internet puisse être facilement trouvé par les crawlers :

- le site Internet propose différents liens vers d’autres pages et est mis en lien sur d’autres sites Internet. De cette façon, les crawlers ne trouvent pas uniquement votre site Internet via des liens et peuvent utiliser votre site Internet comme un nœud de circulation permanent plutôt que comme une voie à sens unique ;

- le contenu du site Internet doit être constamment actualisé et mis à jour. Cela concerne les contenus, les liens et le code HTML ;

- l’accessibilité du serveur doit être garantie ;

- le temps de chargement du site Internet doit être correct ;

- le site ne doit pas comporter de liens et de contenus en double ou superflus ;

- le plan de site, le fichier robots.txt et l’en-tête HTTP Response doivent fournir les principales informations sur le site Internet.

Web crawler et scraper : quelle est la différence ?

Bien qu’ils soient souvent assimilés, les Web crawlers et les scrapers n’appartiennent pas au même type de bots. Alors que les Web crawlers recherchent en premier lieu les contenus du Web, les enregistrent dans des index et les évaluent, les scrapers ont avant tout pour tâche d’extraire les données des sites Internet via le web scraping.

Bien qu’il existe des points communs entre un crawler et un scraper et que les robots d’indexation soient souvent utilisés pour le Web scraping en copiant et en enregistrant les contenus du Web, leur fonction principale consiste à consulter les URL, analyser les contenus et compléter l’index avec de nouveaux liens et de nouvelles URL.

A contrario, les scrapers ont pour fonction première de visiter des URL spécifiques pour extraire des données spécifiques des sites Internet et les enregistrer dans des bases de données pour une utilisation ultérieure.